AI训练芯片 为大模型装上“智商”进化器

《新江南网》江南第一门户网站!

追踪网络热点,关注民生动态,传播江南文化,倡导网络新时代!

两排黑色机柜外泛着幽幽蓝光,机柜格栅中指示灯跳跃闪烁,指引着数据流的方向。空气中,除了冷却系统的嗡鸣,几乎听不到其他声响。这里是人工智能模型的“训练场”,AI训练芯片是核心“教具”。

随着指令下达,AI训练芯片被唤醒,开始执行一项艰巨的任务——训练一个用于自动驾驶汽车的神经网络模型。这个模型需要理解复杂的道路环境,包括行人、车辆、交通标志等,这要求芯片处理庞大的数据集,并从中学习规律。随着训练轮数的增加,大模型的准确性逐渐提高,直到达到令人满意的水平。当下,人工智能产业发展进入“大模型”阶段,海量的数据和超大算力需求,让大模型的产业化落地面临巨大的算力挑战。专门用于处理人工智能应用中的大量计算任务的AI芯片在其中起到了关键作用。在中昊芯英(杭州)科技有限公司,记者见到了中国首枚高性能 TPU(张量处理器)AI训练芯片。银灰色金属片不到半个手掌大,分布着细小的金属触点,一层金属外壳将数百亿的晶体管、复杂的电路和强大的算力包裹其中。就是这样一枚枚小小的芯片,拉近我们与智能的距离,改变着你我的生活,也成为科技创新的必争之地。主攻TPU,AI芯片赛道独辟蹊径原是为图形渲染能力而生的GPU(图形处理器),因在处理计算需求时的性能强于CPU,成为AI时代用于高性能计算的主流方案,近年来其热度飙升,不仅指标性公司的股价不断攀上新高,也有大量创业公司和资本在此寻找机会和追逐梦想。放弃相对成熟、产业链更为完善的GPU芯片,主攻TPU芯片,中昊芯英创始人杨龚轶凡有自己的考量。杨龚轶凡曾在谷歌作为芯片研发核心人员深度参与了谷歌TPU 2/3/4的设计与研发,在他看来,TPU是为AI大模型而生的天然优势架构。从底层架构开始,TPU就与GPU存在本质区别,在指令集、数据传输和计算架构等层面上实现了完全的创新。例如TPU会面向AI做一些定制化的加速,采取二维乃至更高维度的计算单元,让控制单元更小、片上存储器空间更大。因此,TPU芯片用来做AI大模型训练,会比GPU芯片的计算性能更强、功耗更低。中昊芯英的TPU芯片在设计时就考虑了大规模集群的构建需求,有相当大的芯片面积,用来实现片间的互联。而且,中昊芯英的TPU芯片提供了低功耗、高效能的矩阵运算,在性能和能效之间取得了良好平衡,这对于大规模数据中心的建设至关重要。目前,该公司的核心产品已经在国内多个智算中心投入使用。预训练大模型,赋能垂直行业在算力底座之后,更具针对性的行业大模型是下一个兵家必争之地。大模型能做什么?在去年大模型刚落地时,绝大部分的答案是文本生成、文档处理、信息搜索、AI绘画、写代码等。随着AI技术的发展,模型的复杂度也在不断提高。AI训练芯片能够支持这些复杂模型的训练,推动AI技术向更垂直的应用场景发展。在AI芯片行业中,中昊芯英围绕“自研训练芯片+超算集群+AIGC预训练大模型”打造产业价值链。尽管通用大模型展现出广泛适用性,但对于金融数据分析、医学诊断等高度专业化的领域,有很大局限性。聚焦于结构化数据的深度处理与分析,中昊芯英的预训练大模型将以开源形式提供给各行各业的企业,通过对接行业知识库,实现行业大模型的快速部署与应用。比如,中昊芯英与国内头部券商合作打造的金融大模型,能够基于翔实的数据分析,提供投资建议,包括基金净值评估、盈利状况分析等,甚至自动生成数据报表;与省内医学研究机构共同研发的医学大模型,能够根据病患的检查报告进行智能初诊,辅助医生进行疾病鉴别,并基于权威医学知识库提供诊断依据,对于紧急病症,还能触发即时预警,指导紧急处理流程。记者手记市场出考题,时间给答案 中昊芯英的硬件工程师在进行芯片测试验证。在当今全球化的科技竞争格局中,AI芯片作为人工智能领域的核心技术,正日益凸显其战略重要性。长期以来,全球半导体行业由少数几家国际巨头主导,包括中昊芯英在内的众多中国科技企业正在寻求其他解决方案:一方面增加研发投入,力求在芯片设计、新材料、先进制程等方面实现技术突破;另一方面,寻找差异化竞争的市场,力求换道超车,加速国产芯片的研发和产业化。TPU这个诞生不到10年的技术,是否是未来AI计算范式的主流发展方向?中昊芯英认为,只需要在深度学习,甚至更聚焦的大模型这个领域发挥它的有效性,就会有足够高的市场优势和足够广阔的市场空间。高端技术的研发并非一朝一夕,需要持续的投入和不计成本的坚持。随着技术和性能迭代,人工智能在千行百业的广泛应用,只是时间问题,而谁能够成为最后的赢家则需要市场的考验。

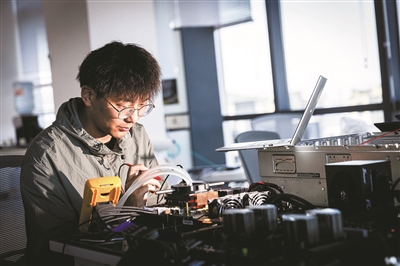

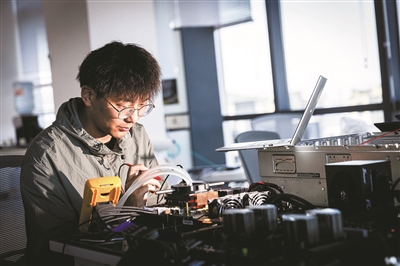

中昊芯英的硬件工程师在进行芯片测试验证。在当今全球化的科技竞争格局中,AI芯片作为人工智能领域的核心技术,正日益凸显其战略重要性。长期以来,全球半导体行业由少数几家国际巨头主导,包括中昊芯英在内的众多中国科技企业正在寻求其他解决方案:一方面增加研发投入,力求在芯片设计、新材料、先进制程等方面实现技术突破;另一方面,寻找差异化竞争的市场,力求换道超车,加速国产芯片的研发和产业化。TPU这个诞生不到10年的技术,是否是未来AI计算范式的主流发展方向?中昊芯英认为,只需要在深度学习,甚至更聚焦的大模型这个领域发挥它的有效性,就会有足够高的市场优势和足够广阔的市场空间。高端技术的研发并非一朝一夕,需要持续的投入和不计成本的坚持。随着技术和性能迭代,人工智能在千行百业的广泛应用,只是时间问题,而谁能够成为最后的赢家则需要市场的考验。

随着指令下达,AI训练芯片被唤醒,开始执行一项艰巨的任务——训练一个用于自动驾驶汽车的神经网络模型。这个模型需要理解复杂的道路环境,包括行人、车辆、交通标志等,这要求芯片处理庞大的数据集,并从中学习规律。随着训练轮数的增加,大模型的准确性逐渐提高,直到达到令人满意的水平。当下,人工智能产业发展进入“大模型”阶段,海量的数据和超大算力需求,让大模型的产业化落地面临巨大的算力挑战。专门用于处理人工智能应用中的大量计算任务的AI芯片在其中起到了关键作用。在中昊芯英(杭州)科技有限公司,记者见到了中国首枚高性能 TPU(张量处理器)AI训练芯片。银灰色金属片不到半个手掌大,分布着细小的金属触点,一层金属外壳将数百亿的晶体管、复杂的电路和强大的算力包裹其中。就是这样一枚枚小小的芯片,拉近我们与智能的距离,改变着你我的生活,也成为科技创新的必争之地。主攻TPU,AI芯片赛道独辟蹊径原是为图形渲染能力而生的GPU(图形处理器),因在处理计算需求时的性能强于CPU,成为AI时代用于高性能计算的主流方案,近年来其热度飙升,不仅指标性公司的股价不断攀上新高,也有大量创业公司和资本在此寻找机会和追逐梦想。放弃相对成熟、产业链更为完善的GPU芯片,主攻TPU芯片,中昊芯英创始人杨龚轶凡有自己的考量。杨龚轶凡曾在谷歌作为芯片研发核心人员深度参与了谷歌TPU 2/3/4的设计与研发,在他看来,TPU是为AI大模型而生的天然优势架构。从底层架构开始,TPU就与GPU存在本质区别,在指令集、数据传输和计算架构等层面上实现了完全的创新。例如TPU会面向AI做一些定制化的加速,采取二维乃至更高维度的计算单元,让控制单元更小、片上存储器空间更大。因此,TPU芯片用来做AI大模型训练,会比GPU芯片的计算性能更强、功耗更低。中昊芯英的TPU芯片在设计时就考虑了大规模集群的构建需求,有相当大的芯片面积,用来实现片间的互联。而且,中昊芯英的TPU芯片提供了低功耗、高效能的矩阵运算,在性能和能效之间取得了良好平衡,这对于大规模数据中心的建设至关重要。目前,该公司的核心产品已经在国内多个智算中心投入使用。预训练大模型,赋能垂直行业在算力底座之后,更具针对性的行业大模型是下一个兵家必争之地。大模型能做什么?在去年大模型刚落地时,绝大部分的答案是文本生成、文档处理、信息搜索、AI绘画、写代码等。随着AI技术的发展,模型的复杂度也在不断提高。AI训练芯片能够支持这些复杂模型的训练,推动AI技术向更垂直的应用场景发展。在AI芯片行业中,中昊芯英围绕“自研训练芯片+超算集群+AIGC预训练大模型”打造产业价值链。尽管通用大模型展现出广泛适用性,但对于金融数据分析、医学诊断等高度专业化的领域,有很大局限性。聚焦于结构化数据的深度处理与分析,中昊芯英的预训练大模型将以开源形式提供给各行各业的企业,通过对接行业知识库,实现行业大模型的快速部署与应用。比如,中昊芯英与国内头部券商合作打造的金融大模型,能够基于翔实的数据分析,提供投资建议,包括基金净值评估、盈利状况分析等,甚至自动生成数据报表;与省内医学研究机构共同研发的医学大模型,能够根据病患的检查报告进行智能初诊,辅助医生进行疾病鉴别,并基于权威医学知识库提供诊断依据,对于紧急病症,还能触发即时预警,指导紧急处理流程。记者手记市场出考题,时间给答案

中昊芯英的硬件工程师在进行芯片测试验证。在当今全球化的科技竞争格局中,AI芯片作为人工智能领域的核心技术,正日益凸显其战略重要性。长期以来,全球半导体行业由少数几家国际巨头主导,包括中昊芯英在内的众多中国科技企业正在寻求其他解决方案:一方面增加研发投入,力求在芯片设计、新材料、先进制程等方面实现技术突破;另一方面,寻找差异化竞争的市场,力求换道超车,加速国产芯片的研发和产业化。TPU这个诞生不到10年的技术,是否是未来AI计算范式的主流发展方向?中昊芯英认为,只需要在深度学习,甚至更聚焦的大模型这个领域发挥它的有效性,就会有足够高的市场优势和足够广阔的市场空间。高端技术的研发并非一朝一夕,需要持续的投入和不计成本的坚持。随着技术和性能迭代,人工智能在千行百业的广泛应用,只是时间问题,而谁能够成为最后的赢家则需要市场的考验。

中昊芯英的硬件工程师在进行芯片测试验证。在当今全球化的科技竞争格局中,AI芯片作为人工智能领域的核心技术,正日益凸显其战略重要性。长期以来,全球半导体行业由少数几家国际巨头主导,包括中昊芯英在内的众多中国科技企业正在寻求其他解决方案:一方面增加研发投入,力求在芯片设计、新材料、先进制程等方面实现技术突破;另一方面,寻找差异化竞争的市场,力求换道超车,加速国产芯片的研发和产业化。TPU这个诞生不到10年的技术,是否是未来AI计算范式的主流发展方向?中昊芯英认为,只需要在深度学习,甚至更聚焦的大模型这个领域发挥它的有效性,就会有足够高的市场优势和足够广阔的市场空间。高端技术的研发并非一朝一夕,需要持续的投入和不计成本的坚持。随着技术和性能迭代,人工智能在千行百业的广泛应用,只是时间问题,而谁能够成为最后的赢家则需要市场的考验。